阿里巴巴达摩院在2025年世界机器人大会上宣布开源具身智能“三大件”,其中包括机器人上下文协议RynnRCP、视觉-语言-动作模型RynnVLA-001-7B和世界理解模型RynnEC。这一举措旨在推动具身智能技术的标准化发展,降低开发门槛,加速机器人在工业、家庭等场景的落地应用。

1. RynnRCP(机器人上下文协议)

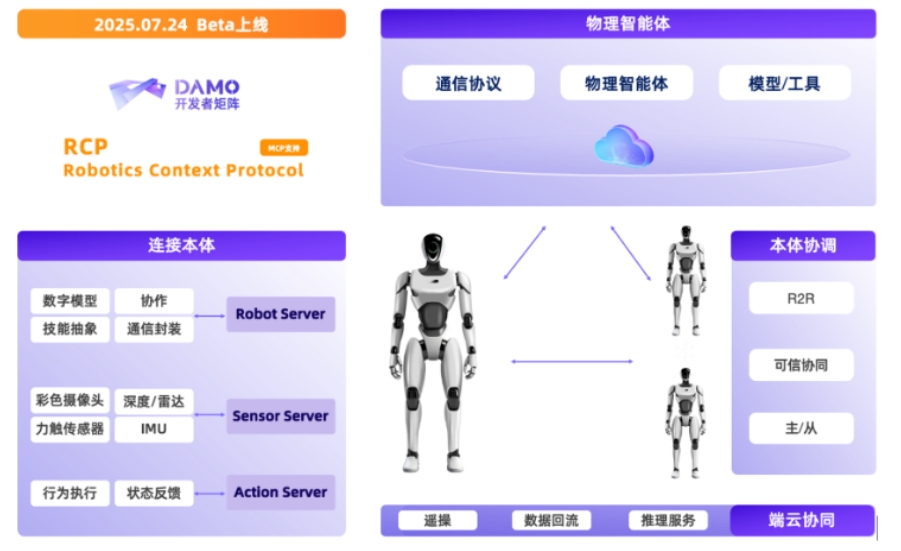

RynnRCP是达摩院首次提出的机器人服务框架,借鉴了模型上下文协议(MCP)的理念,旨在解决机器人开发中的碎片化问题。它主要包含两大模块:

RCP框架:抽象机器人及传感器的功能,提供标准化接口,支持不同传输层和模型服务的交互。

RobotMotion:作为云端推理与机器人控制的桥梁,将低频推理指令转换为高频连续控制信号,确保机器人动作平滑执行。它还提供运动规划、仿真-真机同步等功能,降低开发难度。

目前,RynnRCP已适配Pi0、GR00T N1.5等热门模型及SO-100、SO-101等机械臂,未来还将持续扩展支持范围。

2. RynnVLA-001-7B(视觉-语言-动作模型)

该模型基于视频生成和人体轨迹预训练,能够从第一人称视角视频中学习人类操作技能,并迁移到机器人控制中。例如,在演示中,机械臂能准确识别草莓并执行放置动作。在多项测评中,RynnVLA-001-7B在物品抓取和放置任务中表现优异。

3. RynnEC(世界理解模型)

RynnEC是一个多模态大语言模型(MLLM),可解析物理世界的11个维度(如位置、功能、数量等),仅凭视频流即可建立空间感知,无需3D建模。在RynnEC-Bench基准测试中,其性能超越Gemini-2.5-Pro等顶尖模型。

开源地址

达摩院此次开源旨在提供一套“乐高式工具包”,通过标准化连接、拟人化控制与空间认知三大突破,推动具身智能从实验室走向产业应用。

发表评论 取消回复