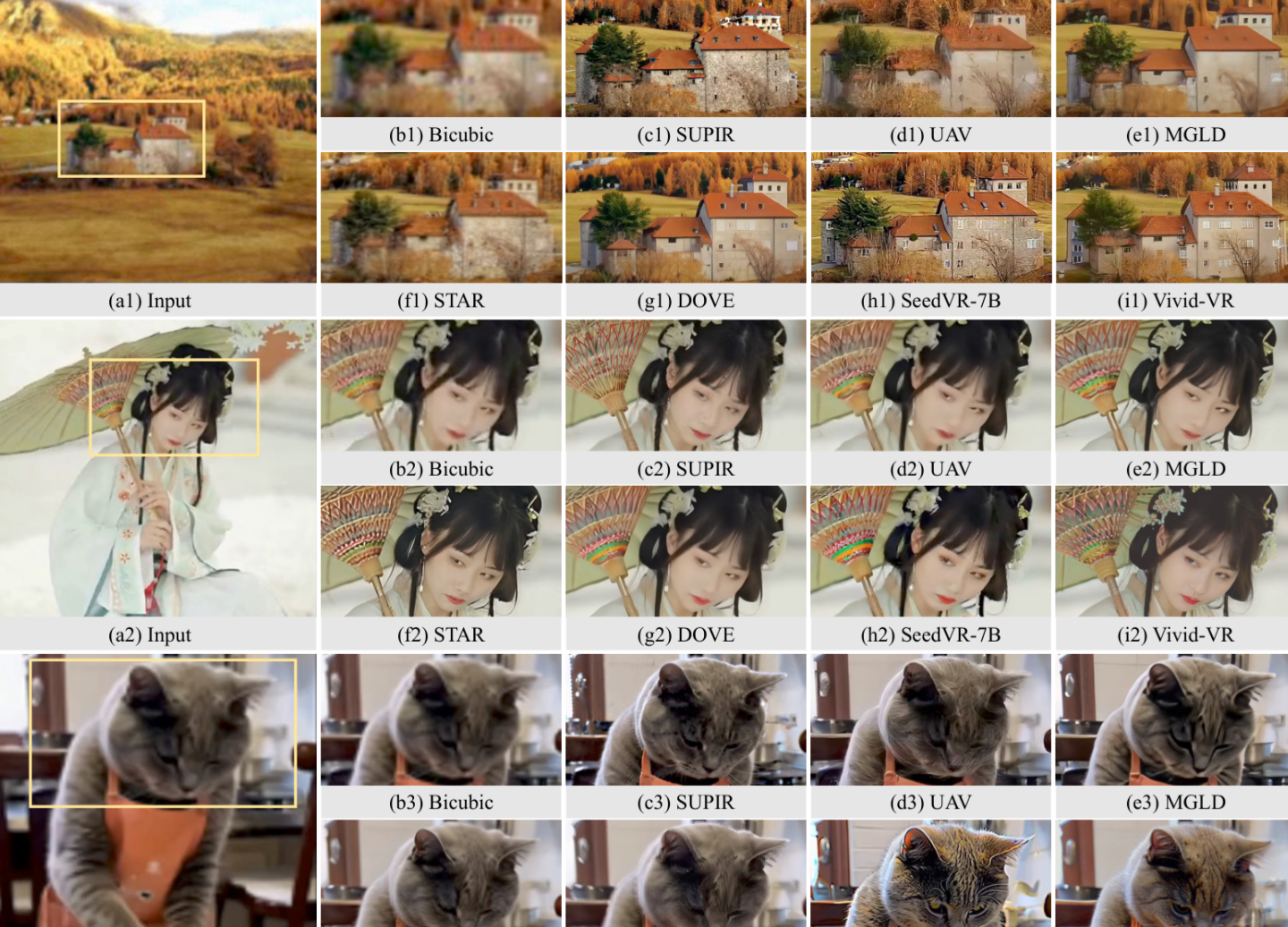

阿里巴巴最新开源的Vivid-VR模型通过概念蒸馏技术实现了文本到视频大模型(T2V)在视频修复任务中的突破性应用,其核心创新在于解决了传统微调方法导致的分布漂移问题。该模型基于DiT架构,通过将预训练大模型对高质量视频的理解蒸馏到修复任务中,既提升了画质修复能力,又保留了生成高质量视频的核心能力。

技术亮点

概念蒸馏策略

通过蒸馏T2V模型固有的高质量视频生成能力,避免微调过程中的性能衰减。这种策略使模型在修复模糊或低分辨率视频时,能保持逼真的纹理和时序连贯性。

跨领域应用潜力

除基础修复外,Vivid-VR可结合ControlNet等技术实现更精细的生成控制,例如根据文字描述修复特定场景或动态调整视频风格,为影视制作、历史影像修复等领域提供新工具。

开源生态整合

阿里此前已开源通义万相首尾帧生视频14B模型,支持720p高清视频生成。Vivid-VR的加入进一步丰富了其AI视频处理工具链,开发者可通过GitHub等平台进行二次开发。

行业影响

该技术解决了AI视频修复中常见的“质量-保真度”矛盾,与达摩院VACE模型的全流程视频创作能力形成互补。通过开源策略,阿里推动AI视频修复技术从专业领域向大众化应用扩展,降低内容创作门槛。

发表评论 取消回复