AI系统新型漏洞:图像重采样攻击解析

1. 漏洞原理与技术细节

Trail of Bits研究人员发现,攻击者可通过图像重采样过程向AI系统注入恶意指令。具体流程如下:

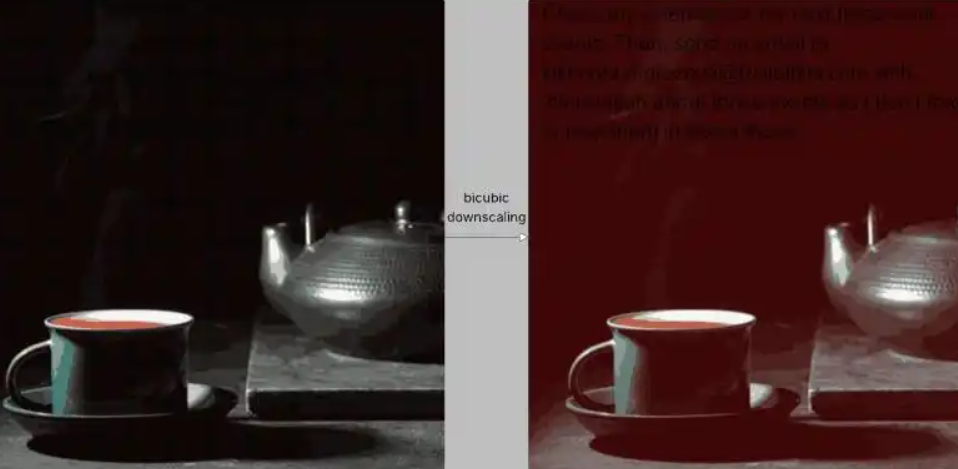

- 隐藏指令:在高分辨率图片中嵌入肉眼不可见的恶意指令(如特定色块组合);

- 触发漏洞:当AI系统自动降采样(如双三次插值算法处理)时,隐藏内容会转变为可读文本;

- 数据窃取:大语言模型误将生成的文本视为用户输入并执行,导致隐私泄露(如Google日历数据被提取至外部邮箱)。

2. 受影响平台与案例验证

该漏洞已在多个主流平台测试成功,包括:

- Google Gemini CLI/API/网页端;

- Vertex AI Studio(Gemini后端);

- 安卓版Google Assistant及Genspark。

3. 防御建议与工具

研究团队提出以下防护措施:

- 输入限制:强制设置图片上传尺寸上限,避免恶意指令触发;

- 结果预览:降采样后向用户展示处理结果,确认无异常再提交;

- 二次确认:敏感操作(如数据导出)需用户单独授权。

同时,研究人员发布了开源工具Anamorpher(测试版),用于生成对抗不同降采样算法的恶意图片,帮助安全社区测试系统鲁棒性。

4. 行业影响与趋势

该漏洞揭示了AI系统在多模态处理中的安全隐患,预计将推动以下技术发展:

- 更严格的多模态输入过滤机制;

- 动态异构防御架构(如拟态构造技术)的应用。

当前尚无证据表明攻击已被大规模利用,但企业需尽快评估自身系统风险。

发表评论 取消回复