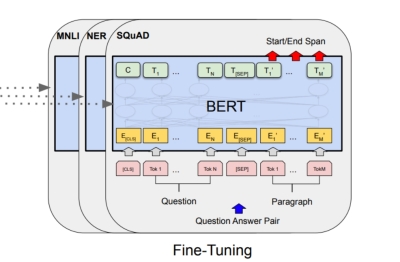

简单来说,微调(Fine-tuning) 是指在预训练大语言模型(Pre-trained Large Language Model, LLM) 的基础上,使用特定领域或任务的数据集进行额外的训练,使模型能够更好地适应目标任务或领域的过程。

你可以把它想象成:

预训练: 模型在大学里接受了广泛的通识教育,学习了语言的基本规则、世界知识、逻辑推理等(通过海量无标注文本)。

微调: 模型毕业后,为了胜任一份具体的工作(比如法律顾问、医疗诊断助手、客服专员、代码生成工程师),需要接受针对性的职业培训(使用特定领域/任务的数据)。

为什么需要微调?

预训练模型虽然拥有强大的通用能力,但在面对具体需求时,直接使用(零样本或少样本提示)往往存在局限:

领域知识不足: 模型可能缺乏特定领域的专业术语、背景知识或表达习惯(如医疗、法律、金融)。

任务格式不匹配: 预训练目标是预测下一个词,而实际任务可能是文本分类、问答、摘要、对话等结构化输出。模型需要学习如何按照特定格式和要求生成内容。

风格/语气不符: 需要模型输出符合特定风格(如正式、幽默、严谨)或品牌声音。

提升特定任务的性能: 在零样本/少样本提示下效果不佳的任务,通过微调可以显著提升准确率、相关性和流畅度。

减少提示工程依赖: 微调后的模型对精心设计的提示词依赖降低,更容易部署和使用。

微调的核心要素

预训练模型: 微调的起点。常见的开源模型如 LLaMA(2/3)、 Mistral、 Qwen、 Baichuan、 ChatGLM 等,或通过 API 可微调的模型(如 OpenAI 的 GPT-3.5 Turbo, Anthropic Claude)。

微调数据集:

任务特定: 用于特定任务(如情感分类、命名实体识别、翻译对)。通常是结构化的(输入-输出对)。

领域特定: 大量特定领域的文本(如医学论文、法律条文、客服对话记录)。用于让模型“沉浸”在该领域的语言环境中。

指令遵循: 包含各种指令和期望输出的数据,用于训练模型更好地理解和遵循人类指令(这对对话助手尤其重要)。

质量要求: 数据质量至关重要。需要清洗、去噪、标注准确,且规模要足够(从几百到几十万条不等,取决于任务复杂度和模型大小)。

微调方法: 这是技术核心,主要有两大类:

全参数微调:

概念: 更新预训练模型的所有参数。

优点: 通常能获得最好的性能潜力。

缺点: 计算成本极高(需要大量 GPU 显存和计算时间),容易过拟合小数据集,存储每个微调版本开销大。

适用场景: 资源极其充足,且追求极致性能的场景。

参数高效微调: 这是当前的主流和热门研究方向。

概念: 只更新模型的一小部分参数(新增少量参数或在原有参数上做低秩变换等),冻结大部分预训练参数。

优点: 显著降低计算成本和显存需求(可在消费级 GPU 上微调大模型),训练更快,过拟合风险更低,易于保存和部署多个适配器。

主流技术:

LoRA: 在模型的注意力层(有时也扩展到 FFN 层)旁路添加低秩矩阵。训练时只更新这些低秩矩阵,然后将其合并回原模型权重用于推理。非常流行且有效。

Prefix-Tuning / Prompt Tuning: 在输入前添加可学习的“前缀”或“提示”向量(软提示),模型在处理输入时会考虑这些向量。只训练这些前缀向量。

Adapter: 在模型的层与层之间(通常是 Transformer 的 FFN 层之后)插入小型神经网络模块(适配器)。训练时只更新适配器参数。

QLoRA: LoRA + 量化。对预训练模型权重进行 4-bit 量化以降低显存占用,同时结合 LoRA 进行微调。使得在单张 24GB GPU 上微调 70B 模型成为可能。

训练目标:

通常使用与预训练相同的自回归语言建模目标(预测下一个词)。

对于结构化任务(如分类、问答),也常使用序列到序列的损失函数(如交叉熵)。

对于指令遵循模型,目标就是最大化在给定指令下生成期望响应的概率。

超参数调整:

学习率: 通常设置得比预训练时小得多(例如 1e-5 到 1e-3),以避免破坏预训练学到的宝贵知识。

批次大小: 受 GPU 显存限制。

训练轮数: 需要监控验证集性能防止过拟合,常用早停策略。

优化器: AdamW 是常用选择。

微调的主要类型(按目标和数据)

任务特定微调: 最常见类型。使用特定任务的数据集(如 IMDb 影评分类数据集)微调模型,使其在该任务上达到最佳性能。

领域自适应微调: 使用大量目标领域的无监督或弱监督文本进行微调,让模型“浸入”该领域的语言风格和知识中,然后再进行任务微调或直接用于该领域的生成任务(如生成医学报告草稿)。

指令微调: 使用包含各种人类指令和期望输出的数据集进行微调。这是创建 ChatGPT、 Claude 等对话助手的关键步骤。目标是让模型学会理解、推理并安全、有帮助、诚实地遵循各种开放式指令。指令微调极大地提升了模型的可用性和泛化能力。

人类偏好对齐微调: 如 RLHF(基于人类反馈的强化学习)或 DPO(直接偏好优化)。在指令微调后,使用人类对模型多个回答的偏好数据,进一步微调模型,使其输出更符合人类价值观(更有帮助、无害、诚实)。RLHF 是 ChatGPT 等模型对齐的关键技术,但实现复杂。DPO 是一种更简单有效的替代方法。

微调的优势

显著提升特定任务/领域的性能。

定制化模型行为(风格、语气、格式)。

注入领域专业知识。

相比从头训练,成本低得多(利用预训练知识)。

参数高效微调使其在资源有限的场景下变得可行。

微调的挑战

高质量数据获取与标注成本高。

计算资源需求(尤其全参数微调)。

过拟合风险(尤其在小数据集上)。

灾难性遗忘: 微调新任务/领域时可能损害模型原有的通用能力。技术如 Elastic Weight Consolidation 或持续学习可缓解。

超参数调整需要经验。

模型管理: 管理多个微调版本可能变得复杂。

潜在偏见放大: 如果微调数据包含偏见,模型可能会放大这些偏见。

微调工具和框架

Hugging Face

transformers+peft+trl: Python 库的黄金组合。transformers提供模型和基础训练,peft提供 LoRA 等参数高效方法,trl提供 RLHF/DPO 实现。DeepSpeed: 微软开发,提供分布式训练优化(如 ZeRO 优化器),极大降低大模型全参数微调的显存需求。

Axolotl: 一个流行的、用户友好的开源项目,封装了上述工具,提供配置文件简化微调流程(尤其支持 LoRA/QLoRA)。

OpenAI API / Anthropic API: 提供通过 API 进行模型微调的服务(简化基础设施管理,但成本可能较高,且模型是黑盒)。

LLaMA-Factory: 另一个功能强大的开源微调框架。

总结

微调是将强大的通用大语言模型转化为解决实际问题的专业工具的核心技术。随着参数高效微调技术(尤其是 LoRA/QLoRA)的成熟和普及,微调的门槛大大降低,使得企业和开发者能够利用有限的资源定制属于自己的 AI 模型,应用于客服、编程辅助、内容创作、专业咨询等广泛场景。理解微调的原理、方法和挑战,对于有效应用 LLM 至关重要。未来,自动化微调、持续学习、多任务联合微调等方向将是研究热点。

发表评论 取消回复